Alibaba випустила «найпотужнішу» LLM-модель для програмування — Qwen3-Coder

Alibaba представила нову велику мовну модель з відкритою ліцензією Qwen3-Coder. У компанії назвали модель найкращим засобом для генерації і роботи з кодом на сьогоднішній день. За деякими параметрами продуктивності вона перевищує не тільки нову модель Kimi K2 від конкуруючого китайського стартапу Moonshot, але й більш відому Claude Opus 4 від Anthropic, повідомляє Venture Beat.

Китайський IT-гігант позиціонує Qwen3-Coder як особливо ефективну в роботі агентного ШІ — автоматизованих процесах, в яких системи штучного інтелекту можуть самостійно вирішувати завдання при написанні коду. Однією з переваг Qwen3-Coder є те, що її версія FP8 дозволяє запускати модель з набагато меншою кількістю пам’яті та обчислювальних ресурсів.

На відміну від багатьох LLM з відкритим кодом, які часто випускають з обмежувальними ліцензіями лише для досліджень або вимагають доступу до API для комерційного використання, Qwen3-Coder орієнтована на локальне розгортання. Завдяки ліцензії Apache 2.0, модель можна вільно використовувати для комерційних цілей.

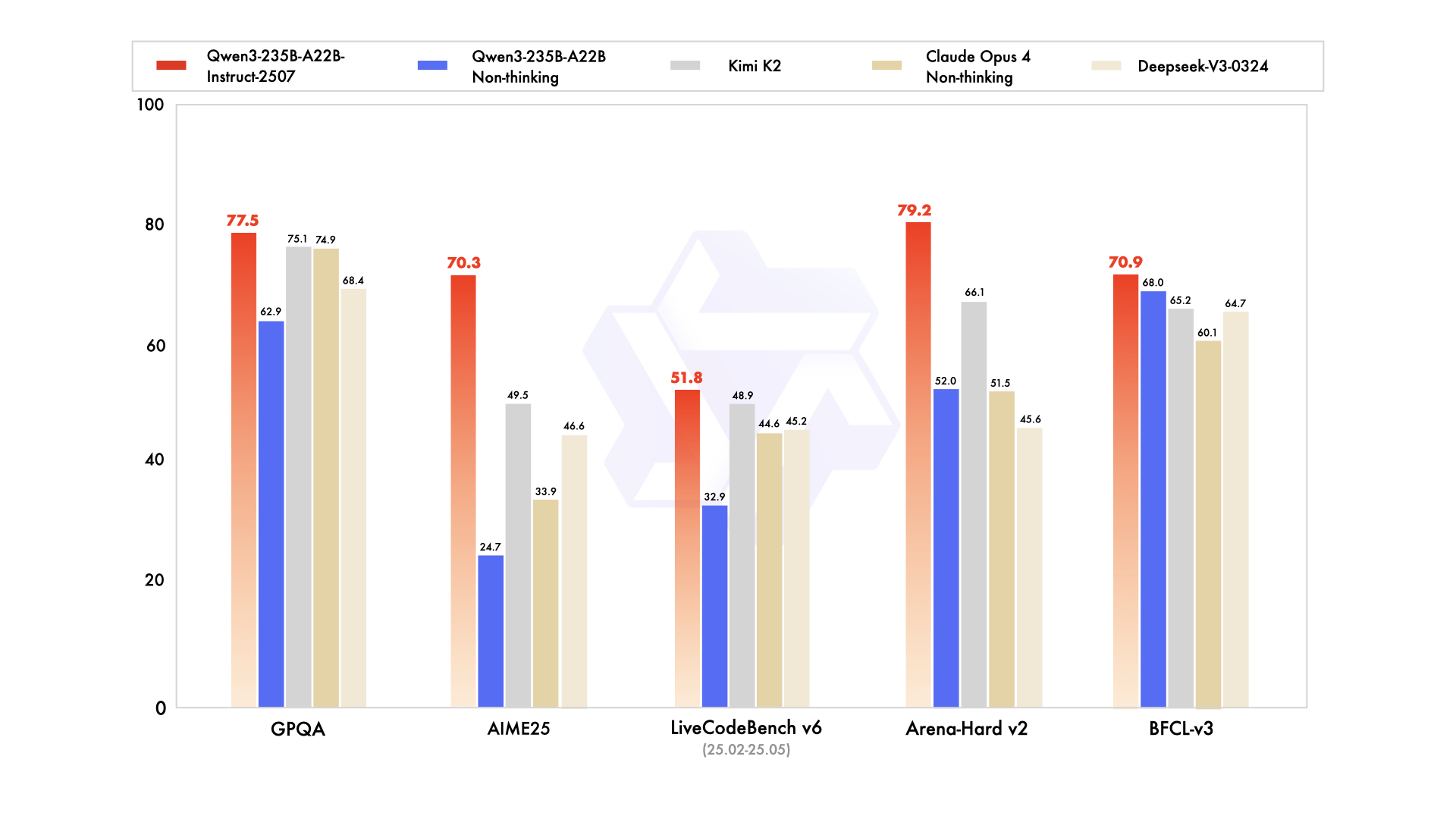

Пол Куверт, викладач штучного інтелекту, опублікував порівняльну таблицю на X, яка показує, що Qwen3-235B-A22B-Instruct-2507 перевершує Claude Opus 4 та Kimi K2 у таких бенчмарках, як GPQA, AIME25 та Arena-Hard v2, назвавши її «потужнішою за Kimi K2… і навіть кращою за Claude Opus 4».

Інфлюенсер ШІ NIK (@ns123abc) прокоментував реліз наступним чином: «Ви смієтеся. Qwen-3-235B зробила Кімі К2 непотрібною лише за один тиждень, незважаючи на те, що вона на чверть менша».

Джефф Будьє, керівник відділу продуктів в Hugging Face, наголошує на перевагах розгортання: «Qwen непомітно випустила масштабне покращення для Qwen3… воно перевершує найкращі відкриті (Kimi K2, в 4 рази більша модель) та закриті (Claude Opus 4) LLM за результатами бенчмарків».

Загальний тон з боку розробників оцінюється вкрай позитивно, оскільки баланс продуктивності, ліцензування та можливостей розгортання моделі подобається як любителям, так і професіоналам.

Сообщить об опечатке

Текст, который будет отправлен нашим редакторам: