OpenAI випустила GPT-5.3-Codex-Spark: пише код у 15 разів швидше, але є нюанс

OpenAI представила дослідницьку preview-версію нової LLM-моделі GPT-5.3-Codex-Spark, яка є полегшеним варіантом GPT-5.3-Codex. За твердженням компанії, вона здатна генерувати код зі швидкістю більше 1000 токенів за секунду, що приблизно в 15 разів швидше, ніж у стандартної версії GPT-5.3-Codex.

Codex-Spark — це перша LLM від OpenAI, розроблена спеціально для роботи з Codex у режимі реального часу. Ви можете переривати її під час виконання завдання для внесення уточнень або зміни логіки. На результат це не вплине.

Codex-Spark також не запускає тести автоматично, якщо не надходить запит. Модель підтримує контекст до 128 КБ, однак доступне лише текстове введення даних.

GPT-5.3-Codex-Spark поки доступна лише для користувачів тарифу Pro вартістю $200 на місяць з окремими обмеженнями протягом періоду попереднього перегляду.

Нова модель призначена для роботи, де важлива швидкість реагування. Під час тестування виявилось, що Codex-Spark суттєво зменшує затримку по всьому конвеєру запит-відповідь. Накладні витрати на кожну передачу клієнт/сервер зменшилися на 80%, а накладні витрати на токен зменшилися на 30%.

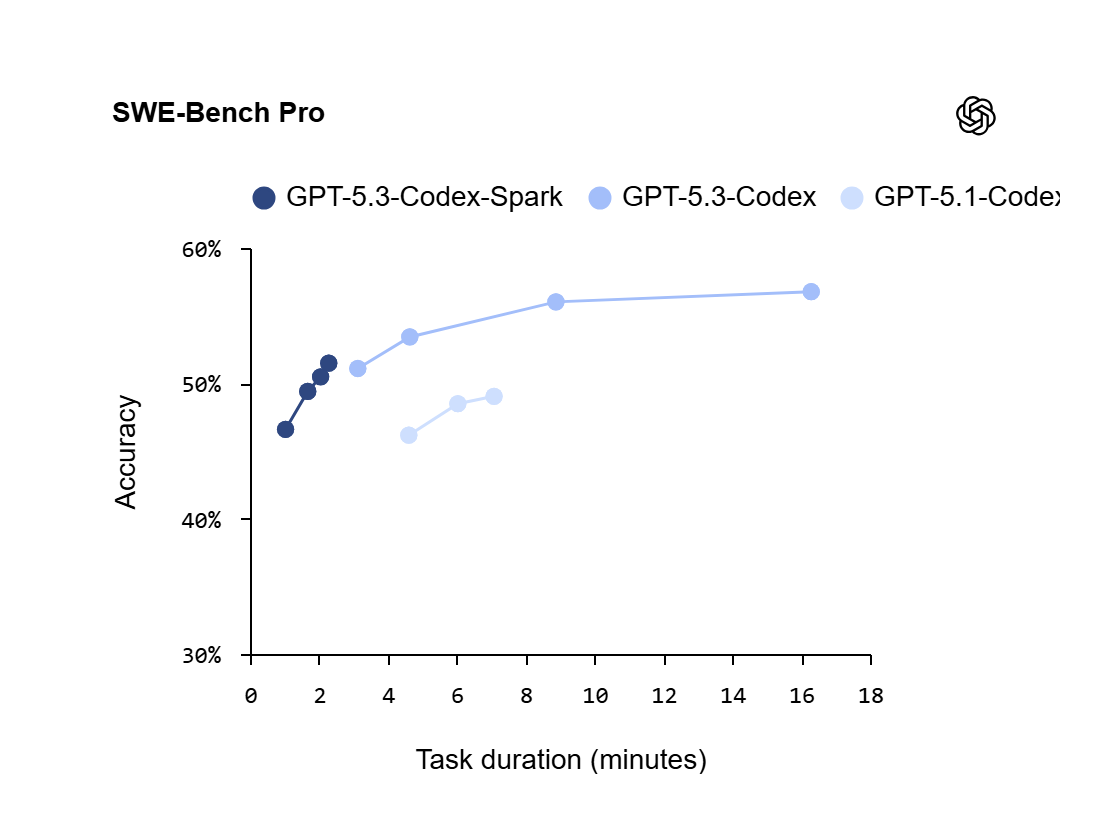

Водночас, в OpenAi визнають, що новинка має недолік. У SWE-Bench Pro та Terminal-Bench 2.0, двох бенчмарках, що оцінюють можливості агентної розробки програмного забезпечення, GPT-5.3-Codex-Spark працює гірше, ніж GPT-5.3-Codex, хоча й може виконувати завдання за значно менший час.

Нагадаємо, вчора стало відомо, що найсучасніші функції Claude стали безкоштовними для всіх.

Підписуйтесь на нас у соцмережах: Telegram | Facebook | LinkedIn

Сообщить об опечатке

Текст, который будет отправлен нашим редакторам: