GPT-5.3-Codex інтегровано в GitHub Copilot: продуктивність агентів зросла на 25%

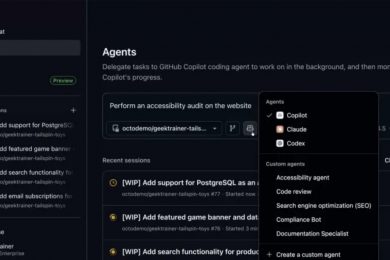

Платформа спільної розробки та хостингу коду GitHub оголосила, що нова LLM-модель GPT-5.3-Codex від OpenAI доступна для розгортання на GitHub Copilot. Внутрішнє тестування виявило, що нова модель підвищила до 25% продуктивність у завданнях агентного кодування порівняно з GPT-5.2-Codex. Про це пише Neowin.

Щоб використовувати нову модель GPT-5.3-Codex, вам потрібно бути клієнтом одного з платних тарифів: Copilot Pro, Pro+, Business або Enterprise. Розробник може обрати модель в меню вибору моделі у Visual Studio Code у всіх режимах (чат, запитання, редагування, агент), github.com, GitHub Mobile (iOS та Android), GitHub CLI та GitHub Copilot Coding Agent.

Клієнтам, які хочуть увімкнути модель в корпоративній мережі з використанням планів Copilot Enterprise або Copilot Business, потрібно звернутись до своїх адміністраторів.

Розгортання моделі GPT-5.3-Codex допоможе тим розробникам, які займаються складною архітектурою програмного забезпечення та автоматизованим рефакторингом. Тепер вони можуть отримати максимальну користь від оновлення LLM завдяки її спеціалізації на агентних робочих процесах. Оскільки це оновлення скорочує час, який займають агентні завдання, на 25%, це допомагає суттєво зменшити затримку, пов’язану з генерацією великих обсягів коду за допомогою штучного інтелекту.

Розгортання новинки від OpenAI відбулося після нещодавнього анонсу про загальну доступність ще однієї потужної моделі від компанії Anthropic — Claude Opus 4.6. LLM цієї серії дуже популярні серед розробників завдяки точності кодування, але останній Codex має скласти для Claude Opus 4.6 здорову конкуренцію. Що стосується GitHub Copilot, то йому важливо пропонувати різноманітні моделі, щоб інструмент міг конкурувати з іншими помічниками кодування.

Нагадаємо, що компанія OpenAI переводить всіх своїх розробників на Codex. Дедлайн — до кінця березня.

Підписуйтесь на наші соцмережі: Telegram | Facebook | LinkedIn

Сообщить об опечатке

Текст, который будет отправлен нашим редакторам: