Українські та європейські вчені випустили MamayLM — першу україномовну LLM-модель

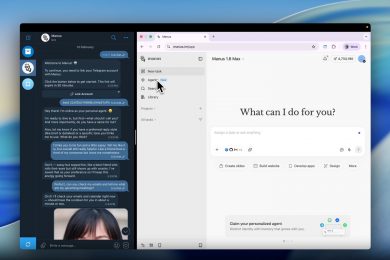

Група дослідників з інституту INSAIT (Болгарія) та ETH Zurich (Швейцарія) представила першу безкоштовну LLM-модель, спеціально навчену для роботи українською мовою. Модель, яка отримала назву MamayLM, має 9 мільярдів параметрів, повідомляє блог Hugging Face.

Як запевняють автори розробки, MamayLM є найефективнішою мовною моделлю для генерації якісних та змістовних відповідей українською мовою. Нова модель демонструє найвищий результат на іспитах ЗНО (Зовнішнє незалежне оцінювання) серед аналогічних LLM подібного розміру, випереджаючи навіть значно більші моделі, такі як Gemma2 27B, Llama 3.1 70B та Qwen 2.5 72B.

MamayLM може працювати локально на одній GPU. Вона побудована на основі моделі Google Gemma 2 9B, яку INSAIT раніше використовував для розробки серії моделей для болгарської мови BgGPT 2.0. Для тренування MamayLM використали 75 мільярдів токенів українського та англійського тексту.

Нова модель MamayLM не тільки адаптована до специфіки української мови, але є експертом у культурних нюансах. Її можна використовувати для особистого використання або для створення додатків та їхньої інтеграції в державні установи — особливо в умовах, коли критично важливо зберігати конфіденційність даних (оскільки модель такого невеликого розміру може працювати локально).

Сообщить об опечатке

Текст, который будет отправлен нашим редакторам: