Kimi 2.5 стала першою LLM-моделлю, яка вміє писати код по зображенню та відео

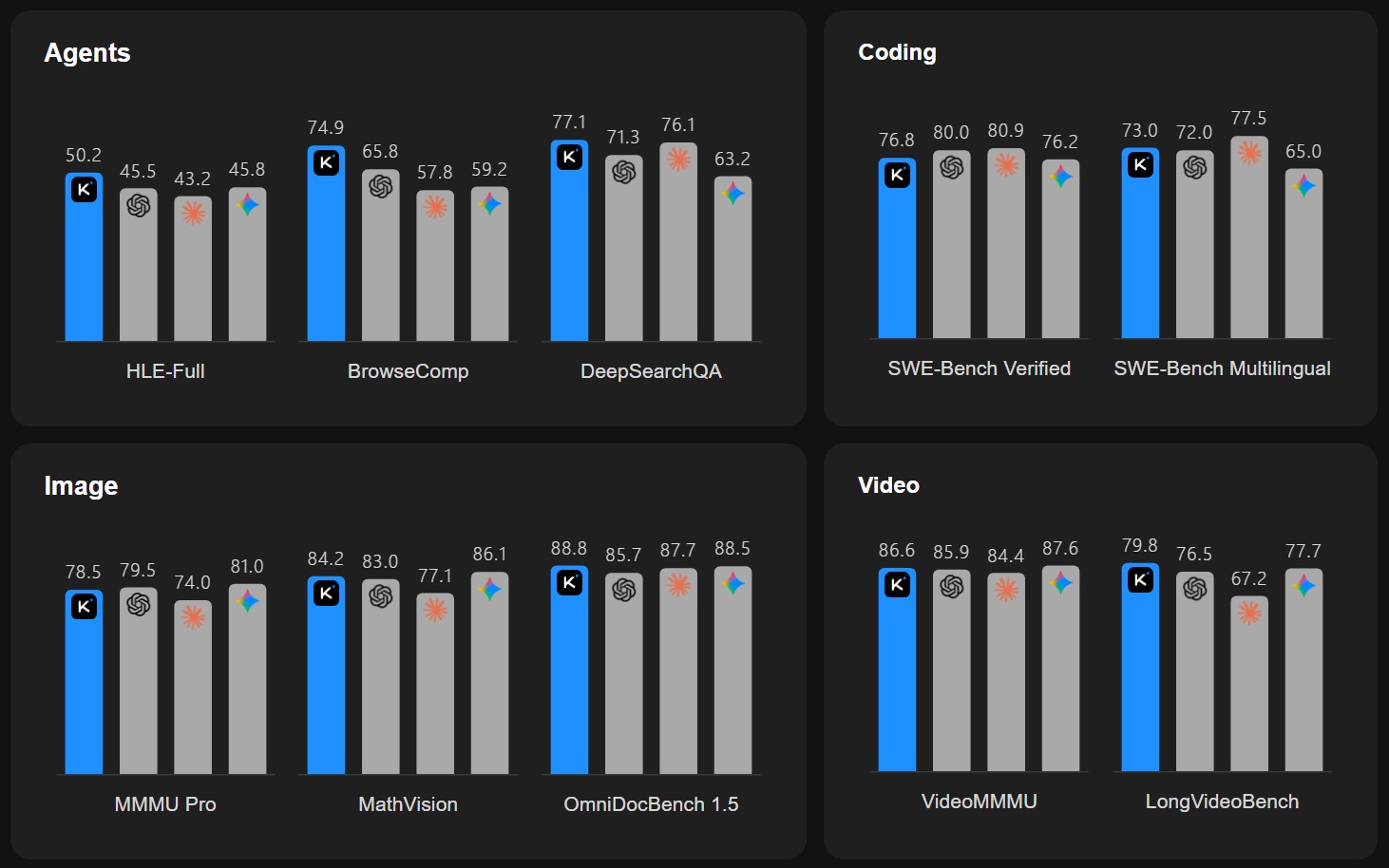

Китайський стартап Moonshot AI випустив оновлення своєї відкритої мультимодальної моделі Kimi. Реліз 2.5 був навчений на рекордних 15 трлн візуально-текстових токенів, пише блог компанії.

Приємною новиною для розробників стало те, що в Kimi 2.5 з’явилась функція coding with vision. Kimi тепер вміє писати та налагоджувати код, спираючись на зображення та відео: відновлювати інтерфейси по візуалах, виправляти вказані на скріншотах баги, перетворювати дизайн або анімацію на робочий фронтенд. Користувач може генерувати програмний код через image/video-to-code.

Moonshot AI запевняє, що нова версія Kimi є найпотужнішою на сьогодні моделлю з відкритим вихідним кодом для завдань з кодування. Крім того, що 2.5 покращує генерацію коду з зображень/відео та візуальне налагодження, вона суттєво знижує технічний бар’єр для користувачів.

Kimi 2.5 доступна через веб-інтерфейс на Kimi.com, у застосунку Kimi, через API та за допомогою коду Kimi Code. Веб-версія та додаток Kimi тепер підтримують 4 режими: K2.5 Instant, K2.5 Thinking, K2.5 Agent та K2.5 Agent Swarm (бета-версія).

Agent Swarm, який поки перебуває у бета-версії на Kimi.com, може самостійно оркеструвати до 100 підагентів і виконувати до 1500 паралельних та поетапних завдань.

Kimi Code працює в терміналі та може бути інтегрований з різними IDE, включаючи VS Code, Cursor та Zed. Цей інструмент теж має відкритий вихідний код та підтримує зображення та відео як вхідні дані. Він також автоматично виявляє та переносить існуючі навички та MCP у ваше робоче середовище в Kimi Code.

Сообщить об опечатке

Текст, который будет отправлен нашим редакторам: